Tecnologia Científica

Novo algoritmo permite que redes neurais aprendam continuamente

Redes neurais têm uma capacidade notável de aprender tarefas específicas, como identificar dígitos escritos à mão. No entanto, esses modelos frequentemente experimentam 'esquecimento catastrófico' quando aprendem tarefas...

Redes neurais têm uma capacidade notável de aprender tarefas específicas, como identificar dígitos escritos à mão. No entanto, esses modelos frequentemente experimentam "esquecimento catastrófico" quando aprendem tarefas adicionais: eles podem aprender com sucesso as novas tarefas, mas "esquecem" como completar a original. Para muitas redes neurais artificiais, como aquelas que guiam carros autônomos, aprender tarefas adicionais requer, portanto, ser totalmente reprogramado.

Cérebros biológicos, por outro lado, são notavelmente flexíveis. Humanos e animais podem facilmente aprender a jogar um novo jogo, por exemplo, sem ter que reaprender a andar e falar.

Inspirados pela flexibilidade dos cérebros humanos e animais, pesquisadores do Caltech desenvolveram agora um novo tipo de algoritmo que permite que redes neurais sejam continuamente atualizadas com novos dados dos quais elas podem aprender sem precisar começar do zero. O algoritmo, chamado de algoritmo de caminho funcionalmente invariante (FIP), tem aplicações de amplo alcance, desde a melhoria de recomendações em lojas online até o ajuste fino de carros autônomos.

O algoritmo foi desenvolvido no laboratório de Matt Thomson , professor assistente de biologia computacional e pesquisador do Heritage Medical Research Institute (HMRI). A pesquisa é descrita em um novo estudo que apareceu no periódico Nature Machine Intelligence em 3 de outubro.

Thomson e o ex-aluno de pós-graduação Guru Raghavan (PhD '23) foram inspirados pela pesquisa em neurociência no Caltech, particularmente no laboratório de Carlos Lois, Professor Pesquisador de Biologia. Lois estuda como os pássaros podem reconectar seus cérebros para aprender a cantar novamente após uma lesão cerebral. Os humanos também podem fazer isso; pessoas que sofreram danos cerebrais por um derrame, por exemplo, muitas vezes podem forjar novas conexões neurais para aprender funções cotidianas novamente.

"Este foi um projeto de anos que começou com a ciência básica de como os cérebros aprendem de forma flexível", diz Thomson. "Como damos essa capacidade a redes neurais artificiais?"

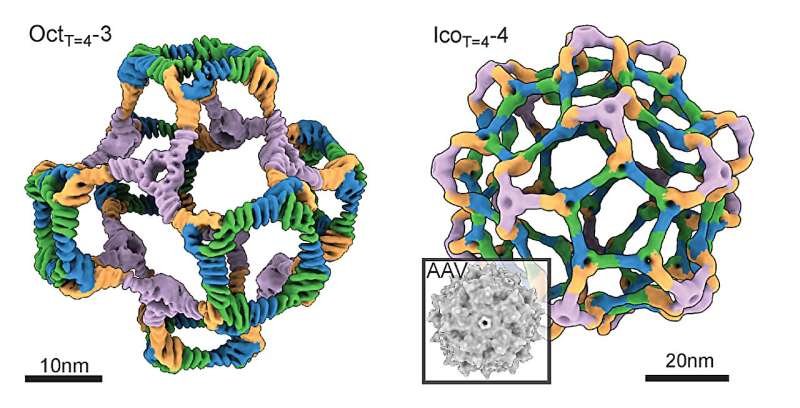

A equipe desenvolveu o algoritmo FIP usando uma técnica matemática chamada geometria diferencial. A estrutura permite que uma rede neural seja modificada sem perder informações previamente codificadas.

Em 2022, com a orientação de Julie Schoenfeld, Caltech Entrepreneur In Residence, Raghavan e Thomson começaram uma empresa chamada Yurts para desenvolver ainda mais o algoritmo FIP e implementar sistemas de aprendizado de máquina em escala para resolver muitos problemas diferentes. Raghavan foi cofundador da Yurts com os profissionais da indústria Ben Van Roo e Jason Schnitzer.

O artigo é intitulado "Engenharia de sistemas flexíveis de aprendizado de máquina atravessando caminhos funcionalmente invariantes". Raghavan é o primeiro autor do estudo. Além de Raghavan e Thomson, os coautores do Caltech são os alunos de pós-graduação Surya Narayanan Hari e Shichen Rex Liu, e o colaborador Dhruvil Satani. Bahey Tharwat da Alexandria University no Egito também é coautor. O financiamento foi fornecido pelo Tianqiao and Chrissy Chen Institute for Neuroscience no Caltech , HMRI, Packard Foundation e Rothenberg Innovation Initiative. Thomson é um membro do corpo docente afiliado ao Tianqiao and Chrissy Chen Institute for Neuroscience no Caltech.